Fase 2, l’oscuro labirinto dei dati

La filosofia è scritta in questo grandissimo libro che continuamente ci sta aperto innanzi a gli occhi (io dico l’universo), ma non si può intendere se prima non s’impara a intender la lingua, e conoscer i caratteri, ne’ quali è scritto. Egli è scritto in lingua matematica, e i caratteri sono triangoli, cerchi, ed altre figure geometriche, senza i quali mezzi è impossibile a intenderne umanamente parola; senza questi è un aggirarsi vanamente per un oscuro labirinto.

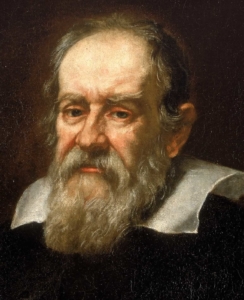

Questo passo del Saggiatore di Galileo, scritto nel 1623, è un testo fondante del moderno pensiero scientifico. Tutta la filosofia galileiana è basata sulla concezione dell’universo come di un sistema ordinato, che soggiace a leggi non arbitrarie, sempre valide e riproducibili. Galileo, uomo di profonda fede, vedeva in quest’ordine un segno dell’intelligenza di Dio: figlia della cultura del suo tempo, profondamente radicata nel pensiero di derivazione scolastica, la filosofia naturale è infatti lo strumento attraverso il quale l’uomo, con il proprio intelletto, giunge a conoscere la creazione e la ragione divina che la governa.

Ma lo scienziato pisano compie un ulteriore passo in avanti, postulando che la comprensione della realtà non sia appannaggio di una riflessione teologica, derivante dall’interpretazione delle Sacre Scritture. A questo risultato si giunge piuttosto per mezzo della matematica, della sperimentazione e della logica razionale. Sarà questo, più che l’adesione al sistema copernicano, a portarlo allo scontro con le istituzioni più intransigenti della Controriforma cattolica del XVI secolo.

La scienza, intesa come metodo scientifico, non si presta a qualunque strumentalizzazione: non lo faceva nel 1600 e non funziona nemmeno oggi. Tuttavia, la tentazione di piegare le sue evidenze al nostro modo di interpretare i fatti è sempre dietro l’angolo: specialmente quando la cruda rappresentazione dei risultati è spiacevolmente lontana da ciò che desideriamo.

A me pare proprio il caso della fase 2.

Secondo le raccomandazioni internazionali già diffuse a marzo dall’Oms, i Paesi che si apprestano ad uscire dal lockdown dovrebbero assicurare efficacia nel tracciare i casi e i contatti, una situazione epidemica con un trend favorevole e un’adeguata capacità di gestione dei casi da parte del Servizio sanitario nazionale.

In coerenza con tali indicazioni il Ministero della Salute, con la sua circolare 15279 del 30/04/2020, costruisce una serie di ben 21 indicatori (divisi in tre aree) i quali, combinandosi in due algoritmi, definiscono per ogni Regione un punteggio di impatto sul servizio sanitario e uno di probabilità di trasmissione dell’epidemia. A loro volta questi parametri (impatto/probabilità di trasmissione) sono raffrontati in una matrice che assegna uno fra 5 livelli di rischio, da “molto basso” a “molto alto”.

Il sistema è stato applicato dal 4 maggio, inizio della fase 2; il primo risultato del monitoraggio è disponibile dal giorno 21 maggio sul sito dell’Iss e indica un quadro piuttosto favorevole, con quasi tutte le regioni a livello “basso” di rischio e solo una in osservazione.

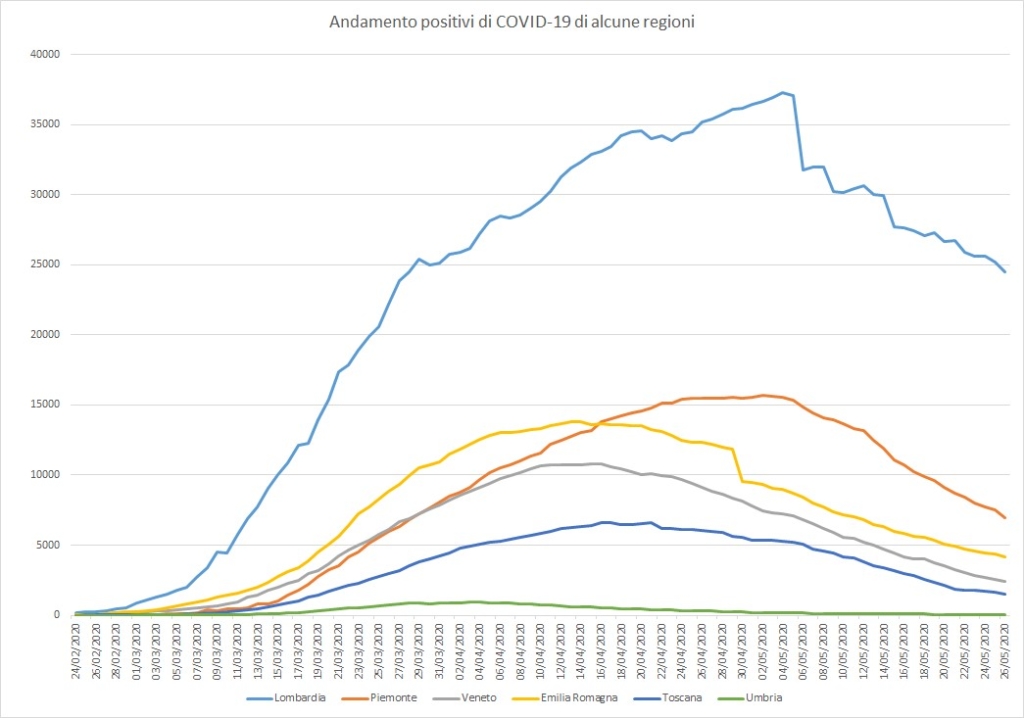

Tuttavia molte fonti autorevoli hanno sollevato diverse critiche a questo sistema, generando non poche preoccupazioni, vista la rilevanza dello strumento per la sicurezza di tutti. Anzitutto, c’è il problema del forte ritardo dei dati: in calce al documento dell’Iss è scritto ad esempio che il tasso Rt (il numero netto di nuovi contagiati per ogni positivo), ossia uno dei principali indicatori, è basato sui dati al 19/5/2020, ma che dopo il 3/5/2020 il dato è da considerarsi incompleto.

Secondo le analisi indipendenti di alcune importanti società scientifiche, questo è solo la punta di un sommerso di ritardi, incompletezza e difformità nella raccolta e nella trasmissione delle informazioni, che rendono molto aleatori i parametri con cui si calcola il rischio.

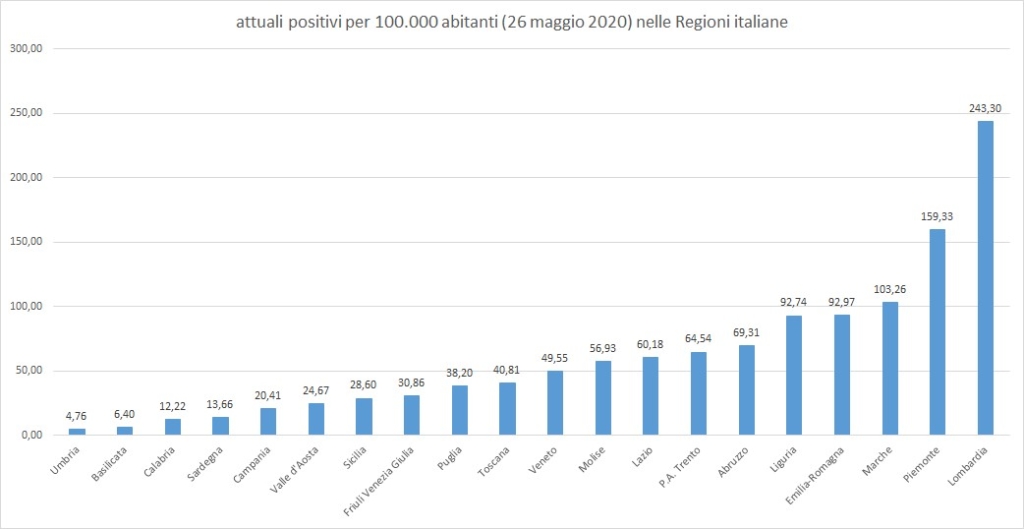

Inoltre c’è il problema, purtroppo difficile da ignorare, che le Regioni, chiamate ad alimentare in autonomia il sistema di sorveglianza, tendano a sottostimare i dati più gravi, temendo di essere penalizzate nelle riaperture, comprensibilmente vitali per l’economia e il consenso politico dei governatori. E osservando i numeri le segnalazione di comportamenti “sospetti” di opportunismo non mancano.

Altre critiche riguardano il meccanismo che stabilisce il punteggio, giudicato eccessivamente farraginoso e burocratico: ad esempio non essendo previsto un parametro basato sul numero complessivo di nuovi casi, ma solo sul loro andamento in percentuale, piccoli incrementi risulterebbero molto penalizzanti proprio per le Regioni più sicure.

In conclusione, il timore è che nonostante gli sforzi, in questa fase 2 il sistema non riesca a “leggere” con la necessaria oggettività i dati, penalizzato da ritardi, interpretazioni e manipolazioni (intenzionali o meno) degli stessi: mancherebbe insomma quella chiarezza galileiana di lettura dei numeri, a cominciare da quelli dei tamponi, la cui quantità quotidiana rimane ben al di sotto di quanto raccomandano i parametri internazionali. Il rischio è che, sfuggendo all’attenzione l’incremento di casi asintomatici, ci si ritrovi di nuovo a contare solo i ricoveri, quando il sistema sanitario è già sotto pressione.

L’impressione è che ci sia ancora della strada da fare, soprattutto per armonizzare e rendere tempestivi i sistemi di ricerca dei contagi, soprattutto fra gli asintomatici. Come sa bene ogni studente di epidemiologia, per ottenere risultati ci vogliono dati: solidi, abbondanti e costantemente alimentati.

Altrimenti, l’oscuro e vano pellegrinaggio nel labirinto rischia davvero di durare a lungo.